웹 브라우저들은 주로 웹 사이트를 크롤링하여 인덱싱을 통해 페이지를 분류하고 검색결과에 뜨게 합니다. 로봇 티엑스티는 텍스트 형식의 파일로 크롤러들이 특정 페이지나 사이트에 접근하지 못하도록 하여 검색창에 뜨지 않도록 하는 기능을 합니다 (다만, 크롤링이 가능한 다른 사이트에 해당 페이지로 이동가능한 링크가 있다면 여전히 접근이 가능하기 때문에 근본적인 접근을 막는 도구는 될 수 없음).

로봇 티엑스티는 사이트맵과 함께 사이트에 대한 접근을 제한하는 공통된 양식으로 강제력은 없지만 대부분의 공신력 있는 브라우저들은 준수하고 있습니다.

주목적은 사이트에 악성 크롤러들이 사이트에 접근하는 것을 사전에 막아 사이트를 보호하는 데 있습니다

사용하기

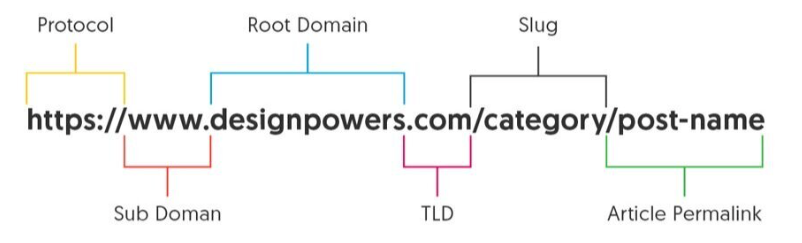

로봇 티엑스티 파일은 프로토콜 및 포트 단위로 추가되어야 하며 웹사이트 코드의 루트에 추가합니다. 예를 들어할 때 로봇티엑티 파일의 경로는 https://www.eg.com/robots.txt가 되며 https://m.eg.com/robots.txt이나 http://eg.com/robots.txt의 도메인에는 적용되지 않습니다.

파일생성

아래와 같이 텍스트 파일을 생성합니다. 파일명은 반드시 robots이어야 하고 UTF-8을 사용하는 텍스트 파일이어야 합니다. 하나의 사이트는 하나의 robots.txt 파일을 가질 수 있습니다.

robots.txt문법

로봇 파일은 대상과 명령어 그룹으로 구성되며 아래와 같습니다.

▶ 에이전트 지정 (대상지정), 그룹 구분 (필수이며 하나의 그룹 안에 복수 지정가능)

User-agent:▶ 접근제한 구문 (접근제한 또는 접근허용 둘 중 하나는 필수이며 하나의 그룹 안에 복수 지정가능)

Disallow:▶ 접근허용 구문 (기본이 허용이기 때문에 생략 시 허용, **접근제한 또는 접근허용 둘 중 하나는 필수이며 하나의 그룹 안에 복수 지정가능)**

Allow:▶ 사이트 맵 구문 (선택이며 **하나의 그룹 안에 복수 지정가능****)**

Sitemap:※ 와일드카드 (*)는 사이트 맵을 제외한 모든 구문에 사용가능하며 사용 시 전체가 허용됩니다 (단, AdsBot 크라울러의 경우 명시적 예외이며 명시적으로 지정필요).

※ 사용되는 경로는 화면에 표시되는 전체경로이어야 하며 디렉터리인 경우 '/'으로 시작해서 '/'으로 끝나야 합니다.

예시,

# Example 1: Block only Googlebot

User-agent: Googlebot

Disallow: /

# Example 2: Block Googlebot and Adsbot

User-agent: Googlebot

User-agent: AdsBot-Google

Disallow: /

# Example 3: Block all crawlers except AdsBot (AdsBot crawlers must be named explicitly)

User-agent: *

Disallow: /[robots.txt 파일 만들기 및 제출 | Google 검색 센터 | 문서 | Google Developers

robots.txt 파일은 사이트의 루트에 위치합니다. robots.txt 파일을 만들고 예를 확인하며 robots.txt 규칙을 확인하는 방법을 알아보세요.

developers.google.com](https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt#submit)

### 각 설정에 대한 추가 설명:

* **`User-agent: *`**: 모든 웹 크롤러에게 이 규칙을 적용한다는 의미입니다.

* **`Allow: /`**: 기본적으로 블로그의 모든 콘텐츠에 대한 크롤링을 허용합니다.

* **`Disallow: /admin/`**: 블로그 관리자 페이지의 크롤링을 차단합니다.

* **`Disallow: /trackback/`**: 트랙백 관련 페이지의 크롤링을 차단합니다.

* **`Disallow: /rss`**: RSS 피드의 크롤링을 차단합니다 (일반적으로 검색 결과에 표시될 필요가 없습니다).

* **`Disallow: /tag/*`**: 태그 페이지의 크롤링을 차단합니다. 태그 페이지는 내용이 중복될 가능성이 높고 SEO 가치가 낮을 수 있습니다.

* **`Disallow: /category/*?`**: 특정 카테고리 필터링 결과를 차단합니다. 이는 블로그의 설정에 따라 다를 수 있으며, 만약 카테고리 페이지가 중요한 경우 이 줄은 제외할 수 있습니다.

* **`Disallow: /search`**: 블로그 내부 검색 결과 페이지의 크롤링을 차단합니다. 이 페이지는 콘텐츠 가치가 낮고 중복으로 간주될 수 있습니다.

* **`Disallow: /m/search`**: 모바일 버전의 내부 검색 결과 페이지 크롤링을 차단합니다. `https://jincolife.com/m/search`와 같은 URL이 여기에 해당합니다.

* **`Disallow: /guestbook/*`**: 방명록 페이지 크롤링을 차단합니다.

* **`Disallow: /attachment/*`**: 첨부 파일(이미지 등) 페이지 크롤링을 차단합니다 (다만, 직접 올린 이미지가 아닌 본문 내 이미지는 괜찮습니다).

* **`Sitemap: https://[블로그주소]/sitemap.xml`**: 검색 엔진에게 블로그의 사이트맵 위치를 알려주어 크롤링 효율을 높입니다. `[블로그주소]` 부분은 실제 블로그 도메인으로 변경해야 합니다.

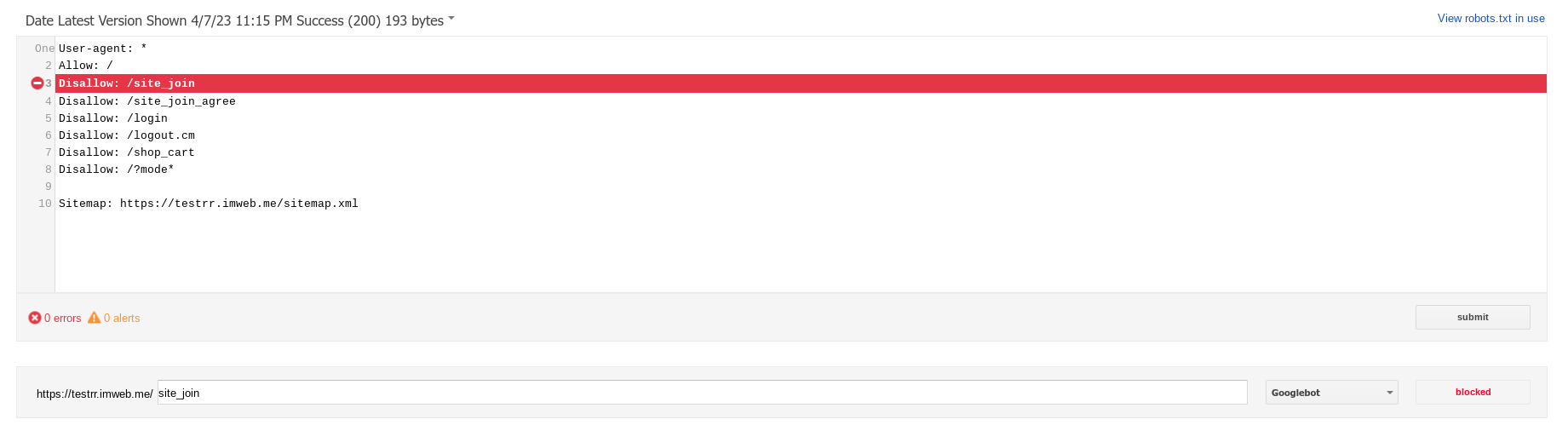

## 적용 후 반드시 구글 서치콘솔에서 확인!

`robots.txt` 파일을 수정한 후에는 반드시 [구글 서치콘솔의 `robots.txt` 테스터](https://www.google.com/webmasters/tools/robots-testing-tool) 기능을 이용하여 변경 사항이 올바르게 적용되었는지, 그리고 원하는 페이지가 차단되거나 허용되는지 확인해 주세요. 적용 후에는 구글이 변경 사항을 반영하는 데 시간이 걸릴 수 있으므로, 꾸준히 서치콘솔의 '색인 생성 범위' 보고서 등을 모니터링하는 것이 중요합니다.티스토리 블로그 robots.txt 최적화 (추가)

이 섹션에서는 티스토리 블로그 사용자분들을 위한 구체적인 robots.txt 설정 방법을 다룹니다. 티스토리는 플랫폼의 특성상 robots.txt 파일을 직접 관리하는 방법이 일반적인 웹사이트와 조금 다릅니다.

티스토리에서 robots.txt 파일 확인 및 수정하기

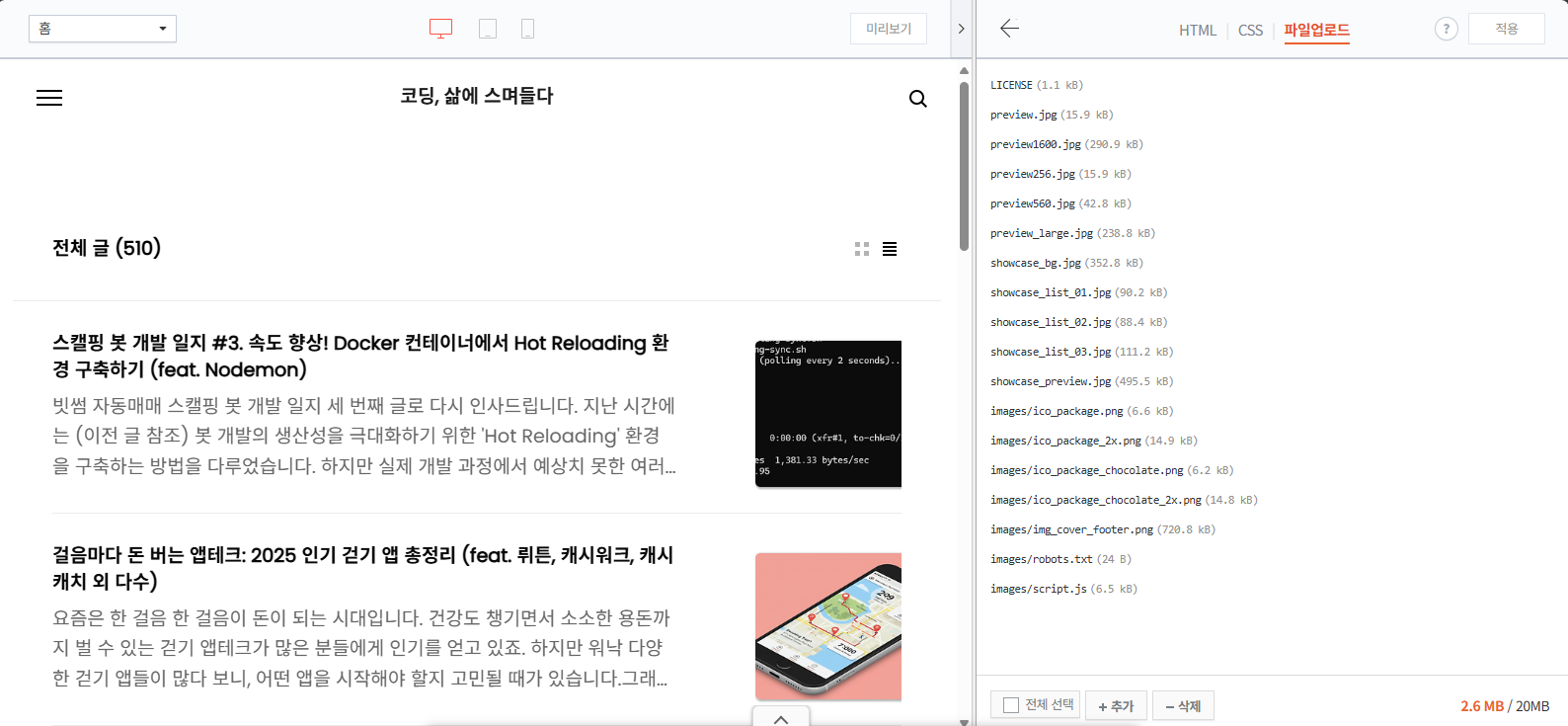

티스토리 블로그의 robots.txt 파일은 스킨 편집 메뉴의 '파일 업로드' 탭을 통해 관리할 수 있습니다.

- 티스토리 관리 페이지 접속: 블로그 관리 페이지에 로그인합니다.

- 스킨 편집 메뉴로 이동: 좌측 메뉴에서 '꾸미기' 아래 '스킨 편집'을 클릭합니다.

- HTML 편집 진입: 스킨 편집 화면 우측 상단의 'HTML 편집' 버튼을 클릭합니다.

- 파일 업로드 탭 선택: HTML/CSS 편집 화면에서 '파일 업로드' 탭을 선택합니다.

- robots.txt 파일 확인/업로드: 이 목록에서

robots.txt파일을 찾거나, 없다면 새로 생성하여 업로드할 수 있습니다. 이미 파일이 존재한다면 덮어씌우거나 삭제 후 다시 업로드하는 방식으로 관리하시면 됩니다. (기존 내용확인은 아래 참고)

참고로, 이미 robot.txt가 있는 경우 내용확인 아래주소를 검색하면 됩니다.

https://<yourblogname>.tistory.com/robots.txt

티스토리 블로그를 위한 robots.txt 권장 설정

일반적인 티스토리 블로그 운영 시, 검색 엔진 최적화(SEO)를 위해 다음과 같이 robots.txt 파일을 설정하는 것을 추천합니다. 특히 /m/search와 같은 내부 검색 결과 페이지는 구글에서 중복 콘텐츠로 인식하거나 크롤링 예산을 낭비하게 할 수 있으므로 차단하는 것이 좋습니다.

테스트

접근가능한 로봇 파일이 존재하는 구글 서치콘솔 테스터로 접근여부의 시험이 가능합니다

[Google Search Console

로그인 Google 검색 콘솔로 이동

accounts.google.com](https://www.google.com/webmasters/tools/robots-testing-tool?utm_source=support.google.com/webmasters/&utm_medium=referral&utm_campaign=%206062598)

참고

https://developers.google.com/search/docs/crawling-indexing/robots/intro

robots.txt 소개 및 가이드 | Google 검색 센터 | Documentation | Google for Developers

robots.txt는 크롤러 트래픽을 관리하는 데 사용됩니다. robots.txt 소개 가이드에서 robots.txt 파일의 정의와 사용 방법을 알아보세요.

developers.google.com

https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt

robots.txt 파일 만들기 및 제출 | Google 검색 센터 | Documentation | Google for Developers

robots.txt 파일은 사이트의 루트에 위치합니다. robots.txt 파일을 만들고 예를 확인하며 robots.txt 규칙을 확인하는 방법을 알아보세요.

developers.google.com

https://developer.mozilla.org/en-US/docs/Learn/Common_questions/Web_mechanics/What_is_a_URL

What is a URL? - Learn web development | MDN

A URL (Uniform Resource Locator) is the address of a unique resource on the internet. It is one of the key mechanisms used by browsers to retrieve published resources, such as HTML pages, CSS documents, images, and so on. In theory, each valid URL points t

developer.mozilla.org

'마케팅 및 SEO' 카테고리의 다른 글

| 검색 엔진최적화 (다국어 블로그) (0) | 2023.04.20 |

|---|---|

| 구글 검색 (0) | 2023.03.31 |

| 애널리틱스 측정기준 및 측정항목 (0) | 2023.02.20 |

| 사이트에서 값(가치) 가져오기 (5) | 2023.02.17 |

| GA4 보고서 - 사용자 (1) | 2023.02.16 |